Exam 70-483

Gerenciar fluxo

Project maintained by shyoutarou Hosted on GitHub Pages — Theme by mattgraham

Este exame é retirado em 31 de janeiro de 2021 às 23h59, horário central. Você não poderá mais fazer o exame após essa data. Saiba mais sobre outros exames que serão retirados aqui

GERENCIAR FLUXO DE PROGRAMA (25–30%)

Processamento multithreading e assíncrono

- Usar a biblioteca Task Parallel, incluindo o Parallel.For method, PLINQ, Tasks; gerar threads usando ThreadPool; desbloquear a UI; usar palavras-chave async e await; gerenciar dados usando coleções simultâneas

ASYNCHRONOUS PROGRAMMING

Os primeiros computadores foram criados seguindo um design lógico chamado “arquitetura von Newmann”, desenvolvido por John von Newmann e outros matemáticos em 1945. Segundo esse design, um computador deve ter uma unidade de processamento, uma unidade de controle, memória e um sistema de entrada e saída (IO). A unidade de processamento e a unidade de controle formam a unidade central de processamento (CPU). Como o design tinha apenas uma unidade de processamento, os programas que precisavam ser escritos para esse tipo de design eram seqüenciais e a maioria das linguagens de programação foi criada para ser usada de maneira sequencial, prática ainda usada nas linguagens de programação atuais, incluindo C#. A maior desvantagem de criar esses aplicativos é que, sempre que seu aplicativo precisava esperar que algo acontecesse, todo o sistema congelava, criando uma experiência do usuário muito desagradável.

Em 1967, Gordon Moore observou que o número de transistores que podem ser ajustados na mesma superfície em um chip de silício está dobrando a cada dois anos. Hoje, essa duplicação acontece a cada um ano e meio. Até 2005, isso se traduzia em várias melhorias, como dobrar a frequência e a velocidade de processamento, dobrar a capacidade, reduzir o tamanho do chip pela metade e assim por diante. Em 2005, a frequência em que uma CPU poderia operar atingiu um platô. Embora os fabricantes de hardware ainda possam seguir a lei de Moore, a frequência não pode ser aumentada sem grandes implicações, principalmente devido ao enorme calor gerado pelo processador, e esse calor precisava ser resolvido. Portanto, para se beneficiar ainda do avanço tecnológico descrito pela lei de Moore, o fabricante de hardware começou a fornecer mais unidades de processamento por processador, conhecidas como núcleos, em vez de aumentar a velocidade. Os desenvolvedores agora enfrentam o maior desafio de suas carreiras, porque muitos estão acostumados a pensar e desenvolver aplicativos para máquinas que possuem apenas um núcleo. Felizmente, a Microsoft já percebeu isso, então criou novas bibliotecas e introduziu novos paradigmas no C# para que a vida pudesse ser mais fácil. Threads foram introduzidos para minimizar esse tipo de problema

MPROCESSING > MPROGRAMMING > MTASKING > MTHREADING

MULTIPROCESSAMENTO

Multi processamento é quando um computador utiliza vários processadores para realizar uma tarefa, processo ou programa simultaneamente.Assim, a tarefa pode ser executada em paralelo. Diminui o tempo de computação. Exemplo: Ao criar um arquivo, o computador usa a hora e a data como padrão.

MULTIPROGRAMAÇÃO

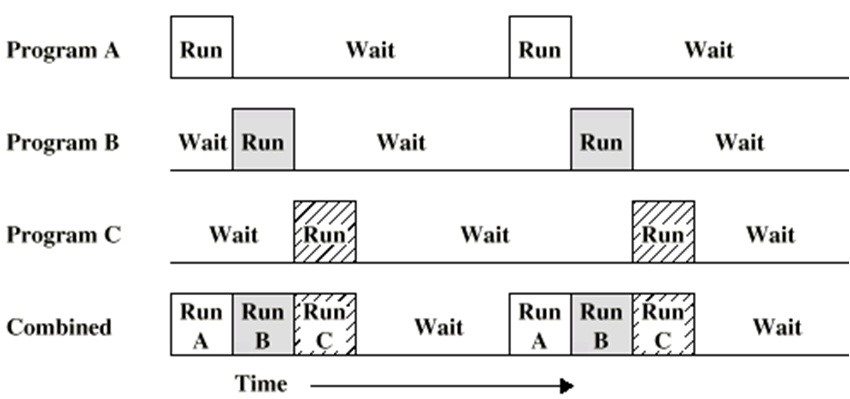

É usado em sistemas operacionais em lote para reduzir o desperdício da CPU, por alternância de contexto de processo. Através de paralelismo lógico e de quantização de tempo (timesharing) a técnica de multiprogramação permite executar várias tarefa/programa/trabalho/processo ao mesmo tempo.

- Processo» Execução de um programa, dinâmica e efêmera (requer mais ou menos recursos, altera estado na execução).

- Programa» Entidade estática (Guardado na memória como arquivo comum) e permanente.

Apenas um programa por vez é capaz de obter a CPU para executar suas instruções, enquanto todos os outros estão esperando a sua vez. Assim, quando termina a sua execução (isto é, no estado de execução) e espera pelo estado periférico (isto é, estado de espera) o sistema operacional seleciona um trabalho a partir do pool de trabalho e inicia sua execução de acordo com um algoritmo de agendamento; quando esse trabalho precisa esperar por operações I/O, a CPU carrega e trabalha em outra tarefa que não está esperando por I/O e pronta para o processo.

Isso está em contraste com a multitarefa, em que cada tarefa recebe um intervalo de tempo (também chamado Quantum) para sua execução.Tanto a multiprogramação como a tarefa são o mesmo conceito de tarefa de comutação no processador, a diferença está no conceito e na razão da comutação.

Ter um processador significava que apenas um thread poderia ser executado a qualquer momento. Isso pode ser alcançado de duas maneiras diferentes:

Todos os algoritmos classificam os processos em estados: Iniciando, Pronto, Executando, Entrada/Saída e Terminado. Ter um processador significava que apenas um thread poderia ser executado a qualquer momento. Isso pode ser alcançado de duas maneiras diferentes:

- Preemptivo» Gentil, respeita prioridade de processos. O sistema operacional possui um componente chamado agendador que garante que nenhum thread monopolize a CPU. É assim que o Windows é implementado.

- Não preemptivo» não respeito FIFO ou SJF(Shortest Job First). todo thread deve abrir mão do controle para que outro thread possa ser executado.

Os algoritmos comuns de escalonamento de sistemas em lote incluem:

| Escalonamento | Descrição |

|---|---|

| FIFO(First In, first Out) FCFS (First Come, first Served) |

Onde o primeiro que chega será o primeiro a ser executado |

| SJF (Shortest Job First) | Onde o menor processo ganhará a CPU. |

| SRT (Shortest Remaining Time) | Neste algoritmo é escolhido o processo que possua o menor tempo restante, mesmo que esse processo chegue à metade de uma operação, se o processo novo for menor ele será executado primeiro. |

| Algoritmo Loteria | O Sistema Operacional distribui tokens (fichas), numerados entre os processos, para o escalonamento é sorteado um numero aleatório para que o processo ganhe a vez na CPU, processos com mais tokens têm mais chance de receber antes a CPU |

| Algoritmo de Prioridade | Cada processo no estado de pronto recebe uma prioridade, os processos com maiores prioridades são executados primeiro. |

| Escalonamento garantido | Se houver N usuários ativos na rede, cada um vai receber em torno de 1/N da capacidade de processamento que um usuário usou para todos os seus processos desde o momento em que tal usuário tornou-se ativo. |

| Round-Robin | Nesse escalonamento o sistema operacional possui um timer, chamado de quantum, onde todos os processos ganham o mesmo valor de quantum para rodarem na CPU, depois que o quantum acaba e o processo não terminou, ocorre uma preempção e o processo é inserido no fim da fila. Com exceção do algoritmo RR, FIFO e garantido, todos os outros sofrem do problema de Inanição (starvation), preemptivo; |

| Múltiplas Filas | São usadas várias filas de processos prontos para executar, cada processo é colocado em uma fila, e cada fila tem uma política de escalonamento própria. |

| Algoritmo Fair-Share | O escalonamento é feito considerando o dono dos processos, onde cada usuário recebe uma fração da CPU e processos são escalonados procurando garantir essa fração. Se um usuário A possui mais processos que um usuário B e os dois têm a mesma prioridade, os processos de A serão mais demorados que os do B. |

Exemplo : Executar um navegador(chrome, Firefox) e enviar um e-mail e executar aplicativo do sistema (MS Word, calculadora ou Excel simultaneamente.

MULTITASKING

Isto é basicamente multiprogramação no contexto de um ambiente interativo single-user ou máquina com um único processador, em que o sistema operacional alterna entre várias tarefas (programa, processo, threads) na memória principal. No sistema multitarefa, também chamado de compartilhamento de tempo, a CPU alterna de uma tarefa para a próxima tarefa (compartilhando recursos comuns, como CPU e memória) tão rapidamente que aparece como todas as tarefas estão sendo executadas ao mesmo tempo. Ou eja, em hardwares equipados com uma única CPU, cada thread é processada de forma aparentemente simultânea, pois a mudança entre uma thread e outra é feita de forma tão rápida que para o utilizador, isso está acontecendo paralelamente. Em hardwares com múltiplos CPUs ou multi-cores, as threads são realizadas realmente de forma simultânea e paralela.

O conceito de multitarefa é bastante semelhante a multiprogramação, mas diferença é que, no multitarefa, o usuário está realmente envolvido com trabalhos diferentes de uma só vez, ou seja, a comutação entre os trabalhos/processos ocorre com tanta freqüência que os usuários podem interagir com cada programa enquanto ele é executado.

Uma tarefa em um sistema multitarefa não é um programa aplicativo inteiro, mas pode se referir a um “thread de execução” quando um processo é dividido em subtarefas, multitarefa não implica paralelismo. Cada tarefa menor não rouba a CPU até que ela termine, eles compartilham uma pequena quantidade do tempo de CPU chamado Quantum. Os sistemas operacionais multiprogramação e multitarefa são sistemas de compartilhamento de tempo.

Algoritmos de escalonamento comuns usados para multitarefa são: Round-Robin, Priority Scheduling (várias filas), Shortest-Process-Next.

Exemplo: ouvir música, jogar jogo, trabalhar no MS Word, Excel e outros aplicativos simultaneamente

CRIANDO APLICAÇÕES RESPONSIVAS

Menos de 20 anos atrás, a maioria dos sistemas operacionais de consumidor (SO) poderia executar um único processo com um thread de execução. (Um thread é a menor unidade de execução que pode ser agendada independentemente pelo sistema operacional.) Em um sistema operacional de Monothread, o computador executa apenas um aplicativo por vez. Normalmente, havia um intérprete de linha de comando que estava interpretando os comandos inseridos pelo usuário. Quando um comando foi inserido, o intérprete transferiu o controle para o processador para o aplicativo ao qual o comando estava se referindo. Quando o aplicativo foi concluído, ele transferiu o controle de volta para o intérprete. Se você pensar bem, isso faz muito sentido, considerando o fato de que você tinha apenas um thread. O maior problema era que o usuário podia sentir que o computador congelou quando um aplicativo fez uma das seguintes coisas:

- Cálculos intensivos: Quando seu aplicativo precisava fazer cálculos intensivos, não havia muito o que fazer, exceto usar um computador mais rápido para diminuir o tempo necessário para fazer o cálculo ou dividir o problema em outros menores e distribuí-lo por vários computadores, ambos com operações caras e, às vezes, pode levar mais tempo para fazer os cálculos.

- Obter dados da E/S: Quando seu aplicativo buscava dados da E/S, sua CPU aguardava a chegada dos dados, sem fazer nenhum processamento no enquanto isso.

Thread

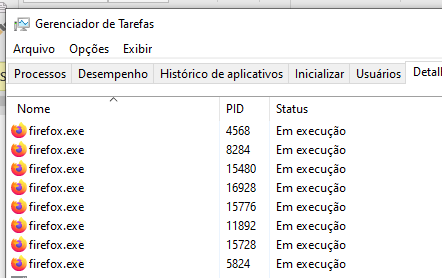

Thread é a unidade de execução básica de um programa em execução. Nas versões atuais do Windows, cada aplicativo é executado em seu próprio processo. Um processo isola um aplicativo de outros aplicativos, fornecendo sua própria memória virtual e garantindo que diferentes processos não possam se influenciar. Cada processo é executado em seu próprio thread. Um thread é algo como uma CPU virtualizada. Se um aplicativo trava ou atinge um loop infinito, apenas o processo do aplicativo é afetado. A Thread é possui seu próprio contador de programa, conjunto do registrador, pilha mas compartilha o código, os dados e o arquivo do processo ao qual pertence, permitindo que um processo tenha vários threads ao mesmo tempo ativos no mesmo espaço de endereço.

- Monothread: Os sistemas que suportam uma única thread (em real execução), uma thread deve aguardar a conclusão de outra ação.

- Multithread: os sistemas que suportam múltiplas threads; o Compartilham o ambiente de execução de um único processo o Em uma CPU de núcleo único, o processo alterna entre threads.

o Em uma CPU com vários núcleos, os dois threads podem executar em paralelo

Exemplo: O melhor exemplo de thread são as guias de um navegador. Se você tem 5 abas que estão sendo abertas e usadas, então o programa realmente cria 5 threads do programa (multi-threading).

O agendador do Windows funciona da seguinte maneira:

- Cada thread recebe uma prioridade atribuída quando é criada. Um thread criado não é iniciado automaticamente; você tem que fazer isso.

- Quando um thread é iniciado, ele será adicionado a uma fila com todos os thread que podem ser executados.

- O planejador pega o thread com a maior prioridade na fila e começa a executá-lo.

- Se vários thread tiverem a mesma prioridade, o planejador os agendará em ordem circular (round robin).

- Quando o tempo alocado terminar, o planejador suspende o thread, adicionando-o no final da fila. Depois disso, ele pega um novo thread para executá-lo.

- Se não houver outro thread com prioridade mais alta que o recém-interrompido, esse thread será executado novamente.

- Quando um thread é bloqueado porque precisa aguardar uma operação de E/S ou por outros motivos, como bloqueio, o thread será removido da fila e outro thread será agendado para execução.

- Quando o motivo do bloqueio termina, o thread é adicionado novamente na fila para ter a chance de ser executado.

- Quando um thread termina o trabalho, o planejador pode escolher outro thread para executá-lo.

Há um thread chamado processo ocioso do sistema que não faz nada, exceto manter o processador ocupado quando não há outro thread para executar. Esse processo de divisão do tempo cria a impressão de que seu sistema operacional pode executar vários aplicativos ao mesmo tempo, incluindo responder aos comandos da interface do usuário que você envia, como mover o mouse ou mover as janelas, etc. A seguir, é apresentada uma lista com alguns desses threads:

- Garbage Collector thread: Responsável pela coleta de lixo.

- Finalizer thread: responsável por executar o método Finalize de seus objetos.

- Main thread: responsável por executar o método do seu aplicativo principal.

- UI thread: se seu aplicativo for um aplicativo Windows Form, um aplicativo WPF ou um aplicativo de armazenamento do Windows, ele terá um thread dedicado para atualizar a interface do usuário

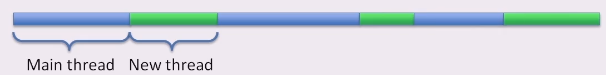

Exceto pelo Main Thread, todos os threads mencionados até agora são background threads. Ao criar um novo thread, você tem a opção de especificar se o thread deve ser um background threads. Quando o thread principal e todos os outros nonbackground threads de um aplicativo .NET terminam, o aplicativo .NET também termina. Com a chegada dos novos processadores multicore e de vários núcleos, os aplicativos escritos de maneira multithread serão inerentemente beneficiados por essas melhorias, enquanto os aplicativos gravados sequencialmente subutilizam os recursos disponíveis e fazem com que o usuário espere desnecessariamente.

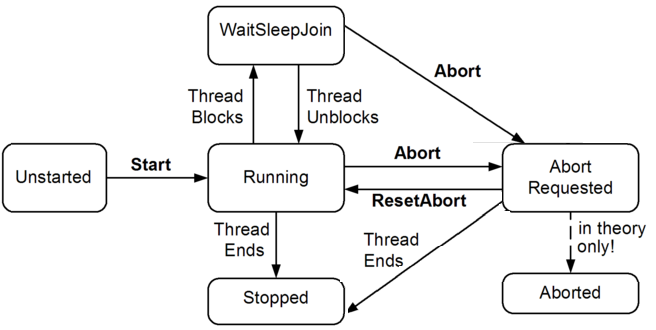

Por padrão, um programa tem um thread chamado Main Thread. O thread principal inicia quando o controle entra no método Main e termina quando o método Main retorna. Um thread pode ser criado usando a classe System.Threading.Thread. Um thread pode ser manipulado apenas em um método. Por exemplo, MainThread precisa de um método Main para controlar o fluxo de um programa. Em um programa C#, um thread pode ser encontrado em qualquer um dos seguintes estados

| Estado | Descrição |

|---|---|

| Não iniciado | O thread foi criado, mas ainda não iniciado |

| Executando | O thread está executando um programa |

| WaitSleepJoin | O thread está bloqueado devido ao método Wait, Sleep ou Join |

| Suspenso | O thread está suspenso |

| Parado | O thread está parado, normalmente ou abortado |

A propriedade ThreadState é útil para fins de diagnóstico, mas inadequada para sincronização, porque o estado de um thread pode mudar entre o teste do ThreadState e a atuação nessas informações.

Usos e mau uso de thread

Multithreading tem muitos usos; aqui estão os mais comuns:

- Manter uma interface de usuário responsiva: Ao executar tarefas demoradas em um thread paralelo de “trabalhador”, o thread principal da interface do usuário fica livre para continuar processando eventos de teclado e mouse.

- Fazer uso eficiente de uma CPU bloqueada: O multithreading é útil quando um thread aguarda uma resposta de outro computador ou peça de hardware. Enquanto um thread é bloqueado durante a execução da tarefa, outros threads podem tirar proveito do computador sem carga.

- Programação paralela: O código que executa cálculos intensivos pode ser executado mais rapidamente em computadores com vários núcleos ou multiprocessadores se a carga de trabalho for compartilhada entre vários threads em uma estratégia de “dividir e conquistar”.

- Execução especulativa: Em máquinas multicore, às vezes você pode melhorar o desempenho prevendo algo que talvez precise ser feito e, em seguida, com antecedência. O LINQPad usa essa técnica para acelerar a criação de novas consultas. Uma variação é executar vários algoritmos diferentes em paralelo que resolvem a mesma tarefa. Qualquer um que terminar primeiro “vence” - isso é eficaz quando você não pode saber antecipadamente qual algoritmo será executado mais rapidamente.

- Permitir que as solicitações sejam processadas simultaneamente: Em um servidor, as solicitações do cliente podem chegar simultaneamente e, portanto, precisam ser tratadas em paralelo (o .NET Framework cria threads para isso automaticamente se você usar ASP.NET, WCF, Serviços da Web ou Remoting). Isso também pode ser útil em um cliente (por exemplo, lidar com redes ponto a ponto - ou mesmo várias solicitações do usuário).

Com tecnologias como ASP.NET e WCF, você pode não estar ciente de que o multithreading está ocorrendo - a menos que você acesse dados compartilhados (talvez por meio de campos estáticos) sem o bloqueio apropriado, sem a segurança do thread.

Threads também tem efeitos colaterais. O maior é que o multithreading pode aumentar a complexidade. Ter muitos threads não cria por si só muita complexidade; mas sim a interação entre os threads (normalmente via dados compartilhados). Isso se aplica se a interação é intencional ou não e pode causar longos ciclos de desenvolvimento e uma suscetibilidade contínua a erros intermitentes e não reproduzíveis. Por esse motivo, vale a pena manter a interação no mínimo e seguir projetos simples sempre que possível.

Uma boa estratégia é encapsular a lógica multithreading em classes reutilizáveis que podem ser examinadas e testadas independentemente. O próprio Framework oferece muitas construções de thread de nível superior, abordadas posteriormente.

O thread também incorre em um custo de recurso e CPU na programação e troca de threads (quando há mais threads ativos que núcleos de CPU) - e também há um custo de criação/desmontagem. O multithreading nem sempre acelera seu aplicativo - pode até abrandá-lo se usado em excesso ou de forma inadequada. Por exemplo, quando operação pesada de E/S está envolvida, pode ser mais rápido que alguns threads de trabalho executem tarefas em sequência do que 10 threads sendo executados ao mesmo tempo.

Gerenciando um thread

A classe Thread não é algo que você deve usar em seus aplicativos, exceto quando você tiver necessidades especiais. No entanto, ao usar a classe Thread, você tem controle sobre todas as opções de configuração. Você pode, por exemplo, especificar a prioridade do seu Thread, informar ao Windows que seu Thread está demorando ou configurar outras opções avançadas. A classe System.Threading.Thread contém os seguintes métodos e propriedades comuns, que são úteis para gerenciar um thread.

| Propriedades | Descrição |

|---|---|

| CurrentContext | Obtém o contexto atual no qual o thread está em execução. |

| CurrentThread | Obtém o thread em execução no momento. |

| IsAlive | Obtém um valor que indica o status de execução do thread atual. |

| IsBackground | Obtém ou define um valor que indica se um thread é ou não um thread de segundo plano. |

| IsThreadPoolThread | Obtém um valor que indica se um thread pertence ao pool de threads gerenciados ou não. |

| ManagedThreadId | Obtém um identificador exclusivo para o thread gerenciado atual. |

| Name | Obtém ou define o nome do thread. |

| Priority | Obtém ou define um valor que indica a prioridade de agendamento de um thread. |

| ThreadState | Obtém um valor que contém os estados do thread atual. |

| Métodos | Descrição |

|---|---|

| Abort() | Gera um ThreadAbortException no thread no qual ele é invocado, para iniciar o processo de encerramento do thread. Geralmente, a chamada a esse método termina o thread. |

| Interrupt() | Interrompe um thread que está no estado de thread WaitSleepJoin. |

| Join() | Bloqueia o thread de chamada até que o thread representado por essa instância termine, enquanto continua a executar COM padrão e o bombeamento de SendMessage. |

| Join(Int32) | Bloqueia o thread de chamada até que o thread representado por essa instância termine ou até que o tempo especificado tenha decorrido, enquanto continua executando o COM padrão e o bombeamento de SendMessage. |

| Join(TimeSpan) | Bloqueia o thread de chamada até que o thread representado por essa instância termine ou até que o tempo especificado tenha decorrido, enquanto continua executando o COM padrão e o bombeamento de SendMessage. |

| Resume() | Retoma um thread que foi suspenso. |

| Sleep(Int32) | Suspende o thread atual no número especificado de milissegundos. |

| Sleep(TimeSpan) | Suspende o thread atual para o período de tempo especificado. |

| Start() | Faz com que o sistema operacional altere o estado da instância atual para Running. |

| Start(Object) | Faz com que o sistema operacional altere o estado da instância atual para Running e, opcionalmente, fornece um objeto que contém dados a serem usados pelo método executado pelo thread. |

| Suspend() | Suspende o thread ou, se o thread já está suspenso, não tem efeito. |

Iniciando um thread

É um processo simples trabalhar com threads:

- Crie um objeto thread .

- Inicie o thread

- Faça mais trabalho no método de chamada.

- Aguarde a thread terminar.

- Continue o trabalho no método de chamada.

Você inicia um thread fornecendo um delegado que representa o método que o thread deve executar em seu construtor de classe. Em seguida, você chama o método Start para iniciar a execução.

| Construtores | Descrição |

|---|---|

| Thread(ParameterizedThreadStart) | Inicializa uma nova instância da classe Thread, especificando um delegado que permite que um objeto seja passado para o thread quando o thread for iniciado. |

| Thread(ParameterizedThreadStart, Int32) | Inicializa uma nova instância da classe Thread, especificando um delegado que permite que um objeto seja passado para o thread quando o thread é iniciado e especificando o tamanho máximo da pilha para o thread. |

| Thread(ThreadStart) | Inicializa uma nova instância da classe Thread. |

| Thread(ThreadStart, Int32) | Inicializa uma nova instância da classe Thread, especificando o tamanho máximo da pilha do thread. |

Dentro do MainThread, um thread pode ser inicializado usando a classe Thread do namespace System.Threading. Um thread pode iniciar sua execução quando um método Thread.Start() é chamado. Os construtores de Thread podem usar um dos dois tipos delegados, dependendo se você pode passar um argumento para o método a ser executado.

ThreadStart

Se o método não tiver argumentos, você passará um ThreadStart é um delegado para o construtor, representa o método que é executado em um thread. Ele tem a assinatura: public delegate void ThreadStart()

O método Start retorna imediatamente, muitas vezes antes do novo thread realmente começar. Você pode usar as propriedades ThreadState e IsAlive para determinar o estado do thread a qualquer momento, mas essas propriedades nunca devem ser usadas para sincronizar as atividades dos threads.

- Referenciando “MyThreadMethod “ usando explicitamente delegate “ThreadStart” sem parâmetros

Thread variableName = new Thread (novo ThreadStart (MyThreadMethod)); - Também podemos referenciar “MyThreadMethod “ para encadear sem usar explicitamente o delegate “ThreadStart”.

Thread variableName = new Thread (MyThreadMethod);

static void MyThreadMethod()

{

Console.WriteLine("Hello From My Custom Thread");

for (int i = 0; i < 10; i++)

{

Console.Write(" {0} ", i);

}

Console.WriteLine();

Console.WriteLine("Bye From My Custom Thread");

}

Thread myThread = new Thread(new ThreadStart(MyThreadMethod));

myThread.Start();

Console.WriteLine("Hello From Main Thread");

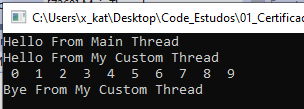

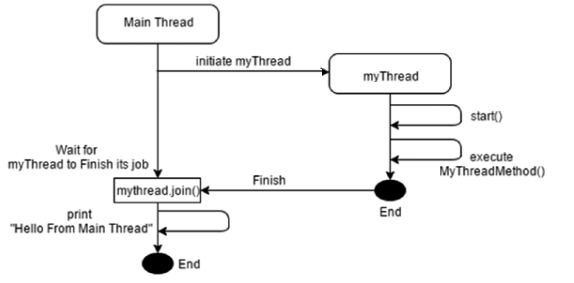

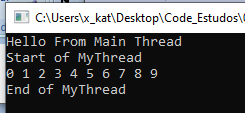

O Tópico Principal inicializa “mythread” e imprime “Hello From Main Thread”. Enquanto “mythread” estava sendo inicializado, “myThread.Start ()” altera seu estado para execução e depois executa “MyThreadMethod ()”. “Hello From Main Thread” fazia parte do MainThread e foi exibido na tela primeiro, porque “myThread” estava demorando para mudar seu estado para execução.

ParameterizedThreadStart

Se o método tiver um argumento, você passará um delegado ParameterizedThreadStart para o construtor. Esta versão do método MyThreadMethod tem um único parâmetro object. Ele tem a assinatura:

public delegate void ParameterizedThreadStart(object obj)

- Exemplo de “MyThreadMethod “ usando impicitamente o delegate “ThreadStart” com parâmetros:

static void MyThreadMethod_Param(Object param)

{

Console.WriteLine("Hello From My Custom Thread");

for (int i = 0; i < (int)param; i++)

{

Console.Write("{0}", i);

}

Console.WriteLine();

Console.WriteLine("Bye From My Custom Thread");

}

Thread myThread = new Thread(MyThreadMethod_Param);

myThread.Start(20);

//OU

Thread myThread_param = new Thread(new ParameterizedThreadStart(MyThreadMethod_Param));

myThread_param.Start(50);

Start(Object)

O Start(Object) faz com que o sistema operacional altere o estado da instância atual para Running e, opcionalmente, fornece um objeto que contém dados a serem usados pelo método executado pelo thread. Quando um thread está no estado de ThreadState.Running, o sistema operacional pode agendá-lo para execução.

public class Work

{

public static void StaticMethod(object data)

{

Console.WriteLine("StaticMethod is running on another thread. Data='{0}'", data);

// Pause for a moment to provide a delay to make threads more apparent.

Thread.Sleep(5000);

Console.WriteLine("StaticMethod called by the worker thread has ended.");

}

public void InstanceMethod(object data)

{

Console.WriteLine("InstanceMethod is running on another thread. Data='{0}'", data);

// Pause for a moment to provide a delay to make threads more apparent.

Thread.Sleep(3000);

Console.WriteLine("InstanceMethod called by the worker thread has ended.");

}

}

// Start a thread that calls a parameterized static method.

Thread newThread = new Thread(Work.StaticMethod);

newThread.Start(42);

Work owork = new Work();

// Start a thread that calls a parameterized instance method.

newThread = new Thread(owork.InstanceMethod);

newThread.Start("The answer.");

Thread.Join()

O método Thread.Join() é usado para manter o thread de chamada em espera até que o thread chamado não seja parado ou sua execução seja encerrada (Similiar ao que ocorre ao métodos delegado e a instrução Task.Wait()). Thread.Join() altera o estado do thread de chamada para ThreadState.WaitSleepJoin. Além disso, o Thread.Join() não pode ser chamado em um thread que não esteja no estado ThreadState.Unstarted.

//Instantiate a thread

Thread myThread = new Thread(new ThreadStart(MyThreadMethod));

//Start the execution of thread

myThread.Start();

//Wait until mythread is terminated

myThread.Join();

//Everything else is part of Main Thread.

Console.WriteLine("Hello From Main Thread");

Desta vez, devido ao método “mythread.Join()”, MainThread (thread de chamada) imprimirá “Hello From Main Thread” por último, porque o método “mythread.join ()” força MainThread (thread de chamada) a esperar até que mythread seja não encerrado.

Thread.Sleep

O Thread.Sleep(5000) é usado para suspender a execução de um thread atual por um número especificado de milissegundos, 5000 milissegundos corresponde a 5 segundos. Thread.Sleep (0) é usado para sinalizar ao Windows que esse thread foi concluído. Em vez de esperar que todo o intervalo de tempo do thread termine, ele mudará imediatamente para outro thread.

O exemplo a seguir usa a sobrecarga do método Sleep(TimeSpan) para bloquear o thread principal do aplicativo cinco vezes, por dois segundos a cada vez.

TimeSpan ts = new TimeSpan(0, 0, 2);

for (int i = 1; i <= 5; i++)

{

Console.WriteLine("Thread paused for {0} second", 2);

// Pause thread for 1 second

Thread.Sleep(ts);

Console.WriteLine("i value: {0}", i);

}

Multi-Threading

Para melhorar a capacidade de resposta do seu aplicativo, foi introduzida a noção de multithreading. Multi-threading é a extensão da multitarefa. Multi-threading é a capacidade de um sistema operacional para subdividir a operação específica dentro de um único aplicativo em threads individuais. Multi-threading aumenta a capacidade de resposta do sistema, pois, se um thread do aplicativo não estiver respondendo, um thread gera outro thread para fazer a busca e a espera enquanto o thread pai continuava executando outro trabalho. Quando os dados eram necessários, o thread pai era bloqueado, aguardando que o thread gerado terminasse seu trabalho e o usuário não precisaria ficar inativo. Esse padrão é conhecido como padrão fork-join.

Em C#, o namespace System.Threading é usado para criar e gerenciar threads em um aplicativo multithread. O multithreading é diferente da multitarefa no sentido de que a multitarefa permite várias tarefas ao mesmo tempo, enquanto o multithread permite que vários threads de uma única tarefa (programa, processo) sejam processados pela CPU ao mesmo tempo. Ou seja, o sistema operacional divide o tempo de processamento não apenas entre aplicativos diferentes, mas também entre cada thread dentro de um aplicativo.

| Comparação | Multitarefa | Multithreading |

|---|---|---|

| Basic | Permite que a CPU execute várias tarefas ao mesmo tempo. | Permite que a CPU execute vários threads de um processo simultaneamente. |

| Comutação | A CPU alterna entre programas com freqüência. | A CPU alterna entre os threads com freqüência. |

| Memória e Recurso | O sistema tem que alocar memória e recursos separados para cada programa que a CPU está executando. | O sistema tem que alocar memória para um processo, vários threads desse processo compartilha a mesma memória e recursos alocados para o processo |

A seguir, estão algumas das desvantagens dos aplicativos multithread:

- Todos os threads consomem muitos recursos. Eles precisam de muita memória (1 MB é padrão) e sempre que o agendador alternar entre os threads, o processador estará ocupado salvando o contexto do thread de suspensão e restaurando o contexto do thread em execução.

- Se seu aplicativo criar muitos threads, a alternância de contexto consumirá uma quantidade considerável de tempo.

- Como o thread precisa de muita memória, geralmente leva uma quantidade considerável de tempo para o sistema criar uma banda de rodagem e também leva algum tempo para destruí-la.

Quando um processo é iniciado, o Common Language Runtime cria automaticamente um única thread de primeiro plano para executar o código do aplicativo. Junto com esse thread de primeiro plano principal, um processo pode criar um ou mais threads para executar uma parte do código do programa associado ao processo. Esses threads podem ser executados em primeiro plano ou em segundo plano. Além disso, você pode usar a classe ThreadPool para executar código em threads de trabalho que são gerenciados pelo Common Language Runtime.

- A thread única, também chamado de thread ‘principal’, é criado automaticamente pelo sistema operacional.

- Uma thread é um caminho de execução e é executada no ambiente isolado do processo. Ou seja, é executada dentro de um processo separado do sistema operacional e opera independentemente de outros caminhos de execução

- Outra thread pode ser criada e iniciada: o Usando a classe Thread o Chamando o método Start

static void RunSequencial()

{

double result = 0d;

// Call the function to read data from I/O

result += ReadDataFromIO();

// Add the result of the second calculation

result += DoIntensiveCalculations();

// Print the result

Console.WriteLine("The result is {0}", result);

}

static void RunWithThreads()

{

double result = 0d;

// Create the thread to read from I/O

var thread = new Thread(() => result = ReadDataFromIO());

// Start the thread

thread.Start();

// Save the result of the calculation into another variable

double result2 = DoIntensiveCalculations();

// Wait for the thread to finish

thread.Join();

// Calculate the end result

result += result2;

// Print the result

Console.WriteLine("The result is {0}", result);

}

static double ReadDataFromIO()

{

// We are simulating an I/O by putting the current thread to sleep.

Thread.Sleep(5000);

return 10d;

}

static double DoIntensiveCalculations()

{

// We are simulating intensive calculations

// by doing nonsens divisions

double result = 100000000d;

var maxValue = Int32.MaxValue;

for (int i = 1; i < maxValue; i++)

{

result /= i;

}

return result + 10d;

}

// We are using Stopwatch to time the code

Stopwatch sw = Stopwatch.StartNew();

// Here we call different methods

// for different ways of running our application.

RunSequencial();

RunWithThreads();

// Print the time it took to run the application.

Console.WriteLine("We're done in {0}ms!", sw.ElapsedMilliseconds);

if (Debugger.IsAttached)

{

Console.Write("Press any key to continue . . .");

Console.ReadKey(true);

}

ThreadPriority

A prioridade da thread define quanto tempo de CPU um thread terá para execução. Quando um thread é criado, inicialmente ele é atribuído com prioridade Normal. Tanto o seu processo como o seu thread têm uma prioridade. A atribuição de baixa prioridade é útil para aplicativos como um protetor de tela. Esse aplicativo não deve competir com outros aplicativos pelo tempo de CPU. Um thread de prioridade mais alta deve ser usado apenas quando for absolutamente necessário. Um thread pode ser atribuído com qualquer uma das seguintes prioridades:

| Prioridade | Explicação |

|---|---|

| High | O thread agendará antes dos threads com qualquer prioridade |

| AboveNormal | O thread será agendado antes dos threads com prioridade normal |

| Normal | Será agendado antes dos Threads com prioridade BelowNormal |

| BelowNormal | O thread será agendado antes dos threads com prioridade mais baixa |

| Lowest | Agendará após Threads com prioridade BelowNormal |

private static void myMethod()

{

//Get Name of Current Thread

string threadName = Thread.CurrentThread.Name.ToString();

//Get Priority of Current Thread

string threadPriority = Thread.CurrentThread.Priority.ToString();

uint count = 0;

while (stop != true) { count++; }

Console.WriteLine("{0,-11} with {1,11} priority has a count = {2,13}",

Thread.CurrentThread.Name, Thread.CurrentThread.Priority.ToString(), count);

}

Thread thread1 = new Thread(new ThreadStart(myMethod));

thread1.Name = "Thread 1";

thread1.Priority = ThreadPriority.Lowest;

Thread thread2 = new Thread(new ThreadStart(myMethod));

thread2.Name = "Thread 2";

thread2.Priority = ThreadPriority.Highest;

Thread thread3 = new Thread(new ThreadStart(myMethod));

thread3.Name = "Thread 3";

thread3.Priority = ThreadPriority.BelowNormal;

thread1.Start();

thread2.Start();

thread3.Start();

Thread.Sleep(10000);

stop = true;

O exemplo acima mostra que o tempo de CPU de um thread depende de sua prioridade. No exemplo, o Thread 2 tem uma prioridade acima dos outros, portanto, incrementa mais o valor da contagem usando mais tempo de CPU. Embora o Thread 3 tenha a menor prioridade, portanto, o número de incrementos é menor que os outros threads.

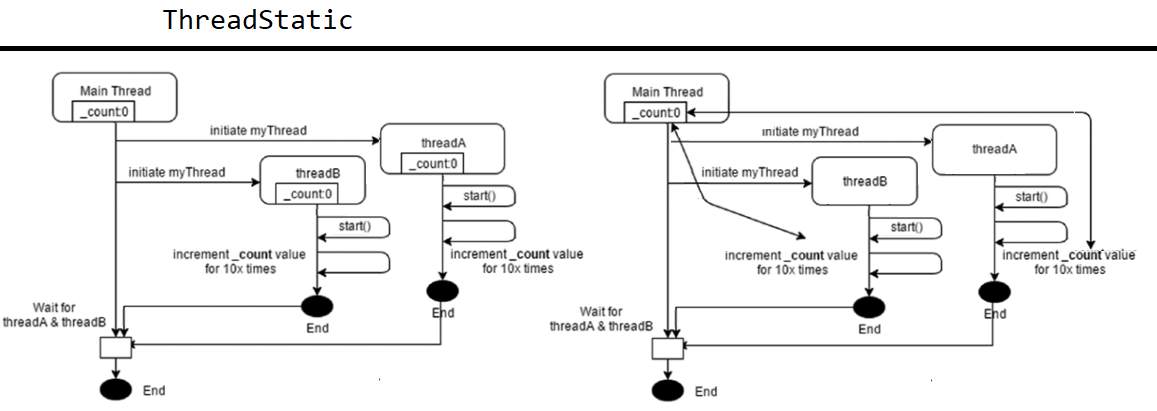

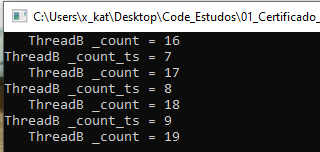

ThreadStatic

ThreadStatic é um atributo usado no topo de um campo estático para tornar seu valor exclusivo (local) para cada thread.

[ThreadStatic]

static int _count_ts = 0;

static int _count = 0;

static void Main(string[] args)

{

Thread threadA = new Thread(() =>

{

for (int i = 0; i < 10; i++)

{

Console.WriteLine("ThreadA _count_ts = {0} ", _count_ts++);

Console.WriteLine(" ThreadA _count = {0} ", _count++);

}

});

Thread threadB = new Thread(() =>

{

for (int i = 0; i < 10; i++)

{

Console.WriteLine("ThreadB _count_ts = {0} ", _count_ts++);

Console.WriteLine(" ThreadB _count = {0} ", _count++);

}

});

threadA.Start();

threadB.Start();

Console.ReadKey();

}

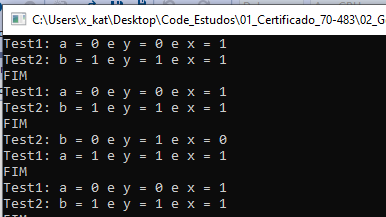

No snippet de código acima, o threadA e o threadB têm seus valores locais exclusivos com o atributo “ThreadStatic” _count_ts. Ambos os threads aumentaram o valor de _count 10 vezes. O resultado final não é 19, porque cada thread aumentou o valor de sua cópia local da variável _count_ts. Na variável _count não marcou com o atributo “ThreadStatic”, portanto, os dois threads compartilharam a mesma variável _count. Quando um thread incrementa o valor de _count, ele afeta o valor da _count que é usada no outro thread chegando o valor até 19.

Classe ThreadLocal

Se você deseja usar dados locais em um thread e inicializá-lo para cada thread, pode usar a classe ThreadLocal

public static ThreadLocal<int> _field = new ThreadLocal<int>(() =>

{

return Thread.CurrentThread.ManagedThreadId;

});

static void Main(string[] args)

{

new Thread(() =>

{

for (int x = 0; x < _field.Value; x++)

{

Console.WriteLine("Thread A: {0}", x);

}

}).Start();

new Thread(() =>

{

for (int x = 0; x < _field.Value; x++)

{

Console.WriteLine("Thread B: {0}", x);

}

}).Start();

Console.ReadKey();

}

Aqui você vê outro recurso do .NET Framework. Você pode usar a classe Thread.CurrentThread para solicitar informações sobre o thread que está sendo executado. Isso é chamado de contexto de execução do thread. Essa propriedade fornece acesso a propriedades como a cultura atual do thread (um CultureInfo associado ao thread atual usado para formatar datas, horas, números, valores de moeda, a ordem de classificação do texto, convenções de maiúsculas e minúsculas) e principal ( representando o contexto de segurança atual), prioridade (um valor para indicar como o thread deve ser agendado pelo sistema operacional) e outras informações.

Quando um thread é criado, o tempo de execução garante que o contexto de execução do thread inicial flua para o novo thread. Dessa forma, o novo thread tem os mesmos privilégios que o thread pai.

Essa cópia de dados custa alguns recursos, no entanto. Se você não precisar desses dados, poderá desativar esse comportamento usando o método ExecutionContext.SuppressFlow.

Threads em primeiro e segundo plano

Threads em segundo plano são idênticos aos threads em primeiro plano com uma exceção: um thread em segundo plano não mantém um processo em execução se todos os threads de primeiro plano tiverem terminado. Depois que todos os threads de primeiro plano forem interrompidos, o tempo de execução interromperá todos os threads em segundo plano e será desligado. As instâncias da classe Thread representam threads em:

- Primeiro plano (Foreground) o O thread do aplicativo principal. o Todos os threads criados chamando um construtor de classe Thread. o Mantem o aplicativo ativo enquanto estiver em execução o Quando concluído, o aplicativo termina e todos os threads em segundo plano são encerrados imediatamente o Por padrão, threads criados explicitamente são threads em primeiro plano

- Segundo plano (Background)

o Threads do pool de threads mantidos pelo tempo de execução. Você pode configurar o pool de threads e agendar o trabalho em threads do pool de threads usando a classe ThreadPool.

o As operações assíncronas que usam as classes Task e Task

baseadas em tarefas são executadas automaticamente em threads do pool de threads. o Todos os threads que entram no ambiente de execução gerenciado por meio de código não gerenciado. o Excelente para tarefas como serviços de pesquisa ou informações de registro

Os threads em segundo plano são úteis para qualquer operação que deve continuar desde que um aplicativo esteja em execução, mas não deve impedir que o aplicativo seja encerrado, como monitoramento de alterações do sistema de arquivos ou conexões de soquete de entrada.

Você pode alterar um thread para ser executado em segundo plano definindo a propriedade IsBackground a qualquer momento. Por padrão, o valor de Thread.IsBackground é falso, que o torna um thread em primeiro plano.

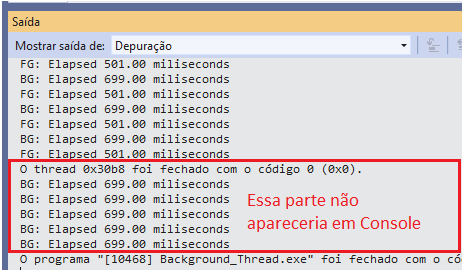

Se você executar o código a seguir com a propriedade IsBackground definida como true, o aplicativo será encerrado imediatamente. Se você defini-lo como false (criando um thread em primeiro plano), o aplicativo imprimirá a mensagem ThreadProc dez vezes.

static void MyThreadMethod()

{

Console.WriteLine("Start of MyThread");

for (int i = 0; i < 10; i++)

{

//suspend the thread for 100 milliseconds

Thread.Sleep(100);

Console.Write("{0} ", i);

}

Console.WriteLine();

Console.WriteLine("End of MyThread");

Console.ReadKey();

}

//Instantiate a thread

Thread myThread = new Thread(new ThreadStart(MyThreadMethod));

//by default Isbackgrount value is always false

myThread.IsBackground = false;

//Start the execution of thread

myThread.Start();

//Everything else is part of Main Thread.

Console.WriteLine("Hello From Main Thread");

O exemplo a seguir ilustra a diferença entre os threads de primeiro plano e de segundo plano sem utilizar a propriedade IsBackground. O método Task.Run é novo no .NET Framework 4.5, ele inicia uma tarefa que é executada em um thread em segundo plano a partir do ThreadPool. Como mostra a saída, o loop é interrompido antes de ser executado por cinco segundos. O Thread.Sleep(500) é usado para suspender a execução de um thread atual por um número especificado de milissegundos.

static void Count()

{

// Set this condition number higher than 8 (which is the condition in Task.Run)

// to see that this foreground thread continues to run when the Task completes

// Set this condition number lower than 8 to see that when this foreground thread

// completes the background task thread ends.

for (int i = 0; i < 4; i++)

{

System.Threading.Thread.Sleep(500);

Console.Write("FG ");

}

}

// Starts a new foreground thread running the Count method

// writes "FG" in the output

Thread t = new Thread(Count);

t.Start();

// Starts a background thread that writes "BG" in the output

Task task = Task.Run(() =>

{

// The task is running on a background thread and will

// produce 8 BG's in the output

for (int i = 0; i < 8; i++)

{

Thread.Sleep(500);

Console.Write("BG ");

}

});

Classe BackgroundWorker

O .NET 2.0 introduziu uma classe chamada System.ComponentModel.BackgroundWorker que abstrai a criação do thread e o uso do pool de threads. A implementação da classe BackgroundWork garante que, em um aplicativo Windows Forms ou WPF, o manipulador de eventos RunWorkerCompleted seja executado por um thread da interface do usuário se RunWorkerAsync for chamado pelo thread da interface do usuário. Em outras palavras, se você iniciar o trabalho em segundo plano dentro de um manipulador de eventos, o evento de conclusão será executado no thread da interface do usuário.

As tabelas a seguir mostram alguns dos métodos, propriedades e eventos que essa classe oferece.

| Propriedade | Descrição |

|---|---|

| CancellationPending | Defina como true se CancelAsync foi chamado para esta operação em segundo plano. |

| IsBusy | Retorna true depois que o RunAsync foi chamado e antes da operação em segundo plano ser concluída. |

| WorkerReportsProgress | Defina essa propriedade como true se desejar que sua operação em segundo plano relate atualizações de progresso. |

| WorkerSupportsCancellation | Defina essa propriedade como true se desejar que sua operação em segundo plano suporte o cancelamento. |

| Método | Descrição |

|---|---|

| RunWorkerAsync | Registra uma solicitação de início para a operação em segundo plano |

| ReportProgress | Gera o evento ProgressChanged |

| CancelAsync | Registra uma solicitação de cancelamento para a operação em segundo plano. |

| Evento | Descrição |

|---|---|

| DoWork | Dispara quando RunWorkerAsync é chamado. É aqui que você chama seu método de execução longa. |

| ProgressChanged | Dispara quando ReportProgress é chamado. |

| RunWorkerCompleted | Dispara quando a operação em segundo plano é concluída. Isso pode ser feito porque a operação foi concluída com êxito, como resposta a uma solicitação de cancelamento ou devido a uma exceção não tratada |

O fluxo de trabalho do uso da classe BackgroundWorker é o seguinte:

- Crie um método que segue a assinatura DoWorkEventHandler.

- Nesse método, chame a operação de execução longa. Quando a operação terminar, atribua o resultado da operação à propriedade Result do parâmetro DoWorkEventArgs.

- Crie uma instância do BackgroundWorker.

- Use o método que você criou na primeira etapa para se inscrever no evento DoWork.

- Crie um método que segue a assinatura RunWorkerCompletedEventHandler.

- Nesse método, obtenha o resultado da operação de longa execução e atualize a interface do usuário.

- Use este método para assinar o evento RunWorkerCompleted, para que seu código saiba quando a operação de longa duração for concluída. Antes de ler o resultado, verifique se a operação de longa execução não gerou uma exceção verificando a propriedade Error do parâmetro RunWorkerCompletedEventArgs. Se a propriedade for nula, significa que nenhuma exceção foi lançada.

- Opcionalmente, crie um método a ser usado para relatar o progresso, seguindo a assinatura ProgressChangedEventHandler e inscrevendo esse método no evento ProgressChanged.

- Chame o método RunWorkerAsync para iniciar o trabalho em segundo plano.

- Se o trabalho oferecer suporte ao cancelamento e você quiser cancelar o trabalho, poderá chamar o método CancelAsync.

Suponha que você tenha um aplicativo Windows Forms que tenha um formulário com um rótulo chamado lblResult e um botão chamado btnRun. Se você usar o método de longa duração da seção anterior juntamente com BackgroundWork, o código resultante pode ter esta aparência

private void btnRun_Click(object sender, EventArgs e)

{

_worker = new BackgroundWorker();

_worker.DoWork += _worker_DoWork;

_worker.RunWorkerCompleted += _worker_RunWorkerCompleted;

if (!_worker.IsBusy)

{

_worker.RunWorkerAsync();

//ERRO de race conditions

//new Thread(() => _worker.RunWorkerAsync()) { Name = "RunWorkThread" }.Start();

}

}

//ERRO de race conditions

//void _worker_RunWorkerCompleted(object sender, RunWorkerCompletedEventArgs e)

//{

// lblResult.Text = e.Result.ToString();

//}

void _worker_RunWorkerCompleted(object sender, RunWorkerCompletedEventArgs e)

{

if (this.InvokeRequired)

this.Invoke(new Action<string>(UpdateLabel), e.Result.ToString());

else

UpdateLabel(e.Result.ToString());

}

private void UpdateLabel(string text)

{

lblResult.Text = text;

}

void _worker_DoWork(object sender, DoWorkEventArgs e)

{

// Ocorre erro pois está tentando atribuir o valor de lblResult.Text

// Que esta no thread da interface (primeiro plano) que chamou o BackgroundWorker

// para realizar a tarefa que está em outro thread em segundo plano

//lblResult.Text = DoIntensiveCalculations().ToString();

e.Result = DoIntensiveCalculations();

}

static double DoIntensiveCalculations()

{

// We are simulating intensive calculations

// by doing nonsens divisions

double result = 100000000d;

var maxValue = Int32.MaxValue;

for (int i = 1; i < maxValue; i++)

{

result /= i;

}

return result + 10d;

}

Observe que:

- Você moveu o código da interface do usuário para seu próprio método. Nesse caso, você chamou o método UpdateLabel.

- No método worker_RunWorkerCompleted, você verifica a propriedade InvokeRequired. Essa propriedade é definida na classe Control e, como tal, está presente em todos os controles em uma página. InvokeRequired é definido como false se você o chamar do thread da interface do usuário e true, caso contrário.

- Se você estiver no thread da interface do usuário, basta chamar o UpdateLabel. Se você estiver em outro thread, deverá chamar o método Invoke, que é definido na classe Control.

- O método Invoke toma como o primeiro parâmetro um delegado, significando que qualquer método pode ser colocado lá. A nova chamada do construtor Action

() é usada para garantir que você obtenha um delegado. Se o seu método tiver uma assinatura diferente, você deverá alterar esse construtor adequadamente. O restante dos parâmetros do método Invoke são enviados diretamente para o método que você deseja executar. Invoke coloca a chamada do método em uma fila para ser atendida pelo thread da interface do usuário.

Race Conditions

Um dos maiores problemas mencionados anteriormente foi que seu aplicativo pode não responder, dando ao usuário a impressão de que o aplicativo está desligado. O motivo disso geralmente ocorre porque um trabalho pesado é colocado no thread responsável pela atualização da interface do usuário. Para melhorar o desempenho percebido do aplicativo, você pode mover esse trabalho pesado para outro thread.

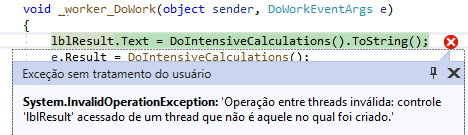

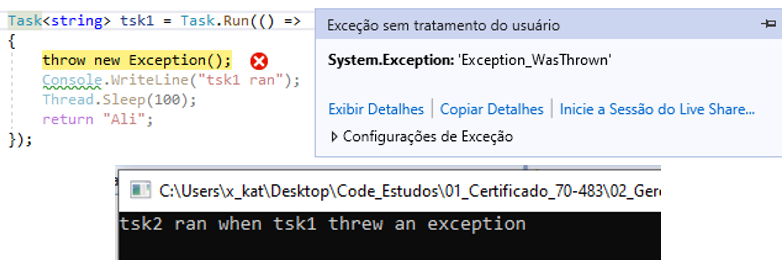

Os aplicativos Windows Forms e WPF têm threads dedicados que atualizam a interface do usuário para evitar uma situação que possa surgir em aplicativos multithread, chamados condições de corrida (race conditions). Uma condição de corrida ocorre quando dois ou mais threads acessam dados compartilhados, para gravação, ao mesmo tempo. Se você tentar atualizar a interface do usuário (thread em primeiro plano) de outro thread (que realiza o serviço, em segundo plano), o .NET Framework emitirá uma InvalidOperationException contendo a seguinte mensagem:

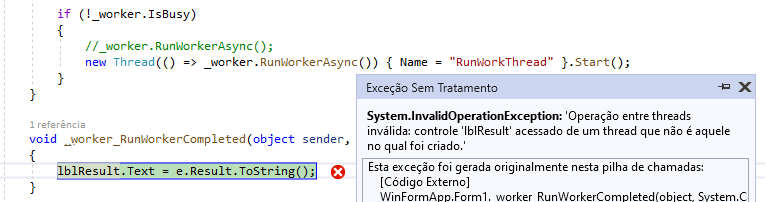

Se o BackgroundWorker for iniciado a partir de outra thread a partir da interface do usuário, você obteria a mesma exceção mencionada anteriormente.

Como nos aplicativos Windows Forms, os aplicativos WPF têm um thread de interface do usuário dedicado. Diferentemente do Windows Forms, o WPF possui um thread extra responsável pela renderização da interface do usuário. Esse segundo thread é privado para o WPF e você não tem acesso a ele no seu aplicativo. O código para o aplicativo WPF parece quase o mesmo do aplicativo Windows Forms, a única diferença é como você atualiza o rótulo - em vez de definir a propriedade Text, você define a propriedade Content. Esta solução sofre do mesmo problema que a solução Windows Forms sofreu. Se o BackgroundWorker for acionado a partir de outro thread que não seja o thread da interface do usuário, quando você tentar atualizar a interface do usuário, o .NET Framework emitirá uma InvalidOperationException. A solução para esse problema é semelhante à da seção anterior, mas é muito mais simples. O worker_RunWorkerCompleted deve se parecer com o seguinte:

void _worker_RunWorkerCompleted(object sender, RunWorkerCompletedEventArgs e) {

// lblResult.Content = e.Result;

// Instead of updating the UI directly we call Dispatcher.Invoke

this.Dispatcher.Invoke(() => lblResult.Content = e.Result);

}

Como você pode ver, basta chamar o método Dispatcher.Invoke em todas as situações. Essa chamada garante que a expressão lambda é executado pelo thread da interface do usuário, independentemente de qual thread o método é chamado. Quando você precisar atualizar a interface do usuário, mantenha o trabalho que não seja da interface do usuário ao mínimo. Você deve despachar apenas o código que atualiza a interface do usuário (no exemplo anterior, apenas o código que atualiza o rótulo). Se no seu código, depois de obter o resultado do BackgroundWorker, você precisar fazer mais processamento antes de atualizar a interface do usuário, faça esse processamento antes de chamar o método Dispatch.Invoke para aplicativos WPF ou o método Invoke para aplicativos Windows Forms.

Se o seu aplicativo for direcionado para o .NET 4.5, o novo modelo de programação async/await cuida disso para você. Se você direcionar uma versão do .NET anterior à 4.5, deverá cuidar disso sozinho.

THREADPOOL

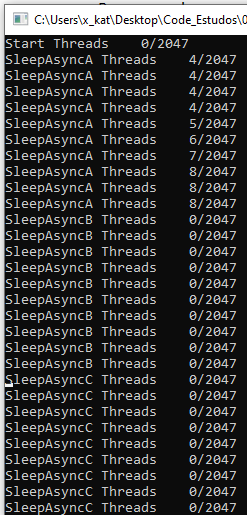

O ThreadPool é uma coleção de threads recicláveis em segundo plano pré-criados por um sistema e estão disponíveis para executar qualquer tarefa quando necessário. Iniciar um novo thread requer recursos (Normalmente algumas centenas de microssegundos), isso pode se tornar visível se muitos threads estiverem sendo criados para operações curtas. Muitos aplicativos também criam threads que passam muito tempo no estado de repouso, aguardando a ocorrência de um evento. Existem situações também em que threads podem entrar em estado de suspensão apenas para serem despertados periodicamente para sondar informações de status de alteração ou atualização.

O pool de threads permite que você use threads com mais eficiência em tais situações, fornecendo ao aplicativo um pool de threads de trabalho que são gerenciados pelo sistema. Quando um programa requer um thread extra, é mais eficiente usar os threads livre disponíveis em na coleção de threads do ThreadPool, pois pode economizar o custo de criação de um thread. Quando um thread conclui sua execução, ele pode voltar ao ThreadPool para que outros programas possam reutilizar o mesmo thread novamente.

Quando o pool de threads reutiliza um thread, ele não limpa os dados no armazenamento local de thread ou em campos que são marcados com o atributo ThreadStaticAttribute ([ThreadStatic] visto anteriormente). Portanto, quando um método examina o armazenamento local do thread ou os campos marcados com o atributo ThreadStatic, os valores que ele encontra podem ser deixados de um uso anterior do thread do pool de threads.

Há um pool de threads por processo. A partir do .NET Framework 4, o tamanho padrão do pool de threads de um processo depende de vários fatores, como o tamanho do espaço de endereço virtual. O pool de threads cria e destrói threads de trabalho a fim de otimizar a taxa de transferência, que é definida como o número de tarefas concluídas por unidade de tempo. Pouquíssimos threads podem não fazer um uso ideal dos recursos disponíveis, enquanto muitos threads podem aumentar a contenção de recursos. Como o ThreadPool limita o número disponível de threads, você obtém um grau menor de paralelismo do que a classe Thread comum. Mas o pool de threads também tem muitas vantagens.

Por exemplo, um servidor Web que atenda solicitações recebidas. Todos esses pedidos chegam em um tempo e frequência desconhecidos. O conjunto de threads garante que cada solicitação seja adicionada à fila e que, quando um thread se torna disponível, é processado. Isso garante que seu servidor não trava com a quantidade de solicitações. Se você estender threads manualmente, poderá facilmente derrubar seu servidor se receber muitas solicitações. Cada solicitação possui características únicas no trabalho que elas precisam fazer. O que o pool de threads faz é mapear esse trabalho nos threads disponíveis no sistema. Obviamente, você ainda pode receber tantas solicitações que fica sem threads. Os pedidos começam a ficar na fila e isso faz com que o servidor da Web não responda. O pool de threads gerencia automaticamente a quantidade de threads necessária para manter-se por perto. Quando é criado, ele começa vazio. Quando uma solicitação é recebida, ele cria threads adicionais para lidar com essas solicitações. Desde que ela possa concluir uma operação antes que uma nova chegue, nenhum novo thread precisa ser criado. Se novos threads não estiverem mais em uso após algum tempo, o conjunto de threads poderá eliminar esses threads, para que não usem mais nenhum recurso.

A classe System.Threading.ThreadPool oferece vários métodos estáticos que você pode chamar para manipular o número de threads no pool de threads que podem ser usados para executar tarefas, postar os itens de trabalho, processar E/S assíncrona, aguardar em nome de outros threads e processar temporizadores. A tabela abaixo lista alguns dos métodos que poedem ser utilizados.

| Método | Descrição |

|---|---|

| CorSetMaxThreads | Função definida no arquivo mscoree.h. Para alterar o número de threads de código não gerenciado |

| GetAvailableThreads | Recupera a diferença entre o número máximo de threads do pool de threads retornados pelo método GetMaxThreads e o número de ativos no momento. Isso representa o número de threads que podem selecionar itens de trabalho da fila. |

| GetMaxThreads | Recupera o número real máximo de threads que podem ser criados pelo pool de threads |

| GetMinThreads | Recupera o número real mínimo de threads que estarão disponíveis no pool de threads |

| QueueUserWorkItem | Adiciona uma solicitação de execução à fila do conjunto de threads. Se houver threads disponíveis no pool de threads, a solicitação será executada imediatamente. |

| SetMaxThreads | Define o número máximo de threads que podem ser criados no pool de threads. |

| SetMinThreads | Define o número mínimo de threads que estarão disponíveis no conjunto de threads a qualquer momento. |

| RegisterWaitForSingleObject | Registra um método a ser chamado quando o WaitHandle é especificado quando o primeiro parâmetro é sinalizado ou quando o tempo limite especificado como quarto parâmetro passa. Esse método possui quatro sobrecargas, uma para cada modo, que o tempo limite pode ser expresso como: int, long, unsigned int ou TimeSpan. |

Essa lista não está completa e é recomendado não utilizar nenhum desses métodos. Dessa lista, é mais provável que você use apenas um método: QueueUserWorkItem. O ThreadPool terá um desempenho melhor com seu próprio algoritmo de alocação de threads. Tocar com os limites do conjunto de threads geralmente resulta em desempenho pior, não melhor. Se você acha que seu aplicativo precisa de centenas ou milhares de threads, há algo seriamente errado com a arquitetura do aplicativo e a maneira como ele está usando threads. O método QueueUserWorkItem tem duas sobrecargas:

public static bool QueueUserWorkItem (WaitCallback callBack)

public static bool QueueUserWorkItem (WaitCallback callBack, Object state)

O parâmetro do tipo System.Threading.WaitCallback, é um delegado definido da seguinte forma:

public delegate void WaitCallback(Object state)

O pool de threads funciona da seguinte maneira. Quando você precisa que um método de execução longa seja executado em um thread separado, em vez de criar um novo thread, chame o método QueueUserWorkItem para colocar um novo item de trabalho em uma fila gerenciada pelo pool de threads. Não é possível cancelar um item de trabalho após ele ter sido enfileirado. Se houver um thread inativo no pool, ele seleciona o item de trabalho e o executa até a conclusão, como qualquer thread. Se não houver um thread disponível e o número total no pool for menor que MaxThreads, o pool criará um novo thread para executar o item de trabalho; caso contrário, o item de trabalho do trabalho aguardará na fila pelo primeiro thread disponível. SetMinThread é usado para preencher previamente o pool com threads para melhorar o desempenho do seu aplicativo quando você souber que irá usar o pool de threads. A prioridade de um thread em pool pode ser alterada (Thread.CurrentThread.Priority = ThreadPriority.AboveNormal) , e ele será restaurado ao normal quando liberado de volta para o pool

static void ThreadProc(Object stateInfo)

{

// No state object was passed to QueueUserWorkItem, so stateInfo is null.

Console.WriteLine("Hello from the thread pool.");

}

static double ReadDataFromIO()

{

// We are simulating an I/O by putting the current thread to sleep.

Thread.Sleep(5000);

return 10d;

}

// Queue the thread.

ThreadPool.QueueUserWorkItem(new WaitCallback(ThreadProc));

Console.WriteLine("Hello From Main Thread.");

// The thread pool uses background threads, its important

// to keep main thread busy otherwise program will terminate

// before the background thread complete its execution

Console.ReadLine(); //Wait for Enter

Console.WriteLine("Hello Again from Main Thread.");

// Queue the thread with Lambda

ThreadPool.QueueUserWorkItem((s) =>

{

Console.WriteLine("Hi I'm another free thread from thread pool");

});

ThreadPool.QueueUserWorkItem((x) => result += ReadDataFromIO());

// Save the result of the calculation into another variable

double result2 = 30;

result += result2;

// Print the result

Console.WriteLine("The result is {0}", result);

Console.ReadLine(); //Wait for Enter

Explicação

- WaitCallback é um delegado que representa um método de retorno de chamada a ser executado por um thread pool thread. O método que ele representa pega um objeto.

- ThreadPool.QueueUserWorkItem enfileira um thread em segundo plano disponível para execução.

- Console.ReadLine mantém a thread principal em espera até o usuário pressionar “Enter”.

Limitação do ThreadPool

- É difícil saber quando um thread de um pool de threads terminou sua execução.

- Não existe um método “Start”, portanto, não podemos saber quando um thread de um pool de threads iniciou sua execução porque está sendo gerenciado pelo sistema.

- Não é possível abortar ou interromper um thread do pool de threads. E o bloqueio de threads em pool pode prejudicar o desempenho

- Você não pode definir o nome de um thread em pool, tornando a depuração mais difícil

- Threads em pool são sempre threads em segundo plano. Ou seja, suas propriedades IsBackground são true. Isso significa que um thread ThreadPool não manterá um aplicativo em execução depois que todos os threads de primeiro plano tiverem saído.

- Não é possível utiliar Join em um thread do pool de threads. Para conseguir isso, você deve usar alguns outros mecanismos.

- Não é possível gerenciar um thread que retorna um valor.

Exemplos de operações que usam ThreadPool:

- Quando você cria um objeto Task ou Task

para executar alguma tarefa de forma assíncrona, por padrão, a tarefa é agendada para ser executada em um thread do pool de threads. - Temporizadores assíncronos usam o pool de threads. Threads de pool de threads executam retornos de chamada da classe System.Threading.Timer e geram eventos da classe System.Timers.Timer.

- Quando você usa identificadores de espera registrados, um thread do sistema monitora o status dos identificadores de espera. Quando uma operação de espera é concluída, um thread de trabalho do pool de threads executa a função de retorno de chamada correspondente.

Delegados assíncronos

O ThreadPool.QueueUserWorkItem não fornece um mecanismo fácil para recuperar valores de retorno de um thread após a conclusão da execução. Invocações de delegado assíncronas (delegados assíncronos para breve) resolvem isso, permitindo que qualquer número de argumentos digitados seja transmitido nas duas direções. Além disso, as exceções não tratadas nos delegados assíncronos são reconvertidas no thread original (ou mais precisamente, no thread que chama EndInvoke) e, portanto, não precisam de tratamento explícito.

Veja como você inicia uma tarefa de trabalho por meio de um delegado assíncrono:

- Instancie um delegado visando o método que você deseja executar em paralelo (normalmente um dos delegados predefinidos do Func).

- Chame BeginInvoke no delegado, salvando seu valor de retorno IAsyncResult. a. BeginInvoke retorna imediatamente para o chamador. Você pode executar outras atividades enquanto o thread em pool estiver funcionando.

- Quando você precisar dos resultados, chame EndInvoke no delegado, passando o objeto IAsyncResult salvo.

No exemplo a seguir, usamos uma chamada de representante assíncrona para executar simultaneamente com o thread principal, um método simples que retorna o comprimento de uma string:

static int Work(string s) { return s.Length; }

Func<string, int> method = Work;

IAsyncResult cookie = method.BeginInvoke("test", null, null);

//

// ... here's where we can do other work in parallel...

//

int result = method.EndInvoke(cookie);

Console.WriteLine("String length is: " + result);

EndInvoke faz três coisas

- Aguarda o delegado assíncrono concluir a execução, se ainda não o tiver feito.

- Ele recebe o valor de retorno (assim como quaisquer parâmetros ref ou out).

- Lança qualquer exceção de trabalhador não tratado de volta ao thread de chamada.

Se o método que você está chamando com um delegado assíncrono não tiver valor de retorno, você ainda (tecnicamente) é obrigado a chamar o EndInvoke. Se você optar por não chamar para o EndInvoke, no entanto, precisará considerar o tratamento de exceções no método worker para evitar falhas silenciosas.

Você também pode especificar um delegado de retorno de chamada ao chamar BeginInvoke - um método que aceita um objeto IAsyncResult que é chamado automaticamente após a conclusão. Isso permite que o thread instigador “esqueça” o delegado assíncrono, mas requer um pouco de trabalho extra no final do retorno de chamada:

static int Work(string s) { return s.Length; }

static void Done(IAsyncResult cookie)

{

var target = (Func<string, int>)cookie.AsyncState;

int result = target.EndInvoke(cookie);

Console.WriteLine("String length is: " + result);

}

Func<string, int> method = Work;

method.BeginInvoke("test", Done, method);

O argumento final para BeginInvoke é um objeto de estado do usuário que preenche a propriedade AsyncState de IAsyncResult. Pode conter qualquer coisa que você quiser; nesse caso, estamos usando-o para passar o delegado do método para o retorno de chamada de conclusão, para que possamos chamar EndInvoke nele.

Thread.Abort

Para parar um thread, você pode usar o método Thread.Abort. Esse método gera um ThreadAbortException no thread no qual ele é invocado, para iniciar o processo de encerramento do thread. Geralmente, a chamada a esse método termina o thread. No entanto, como esse método é executado por outro thread, pode acontecer a qualquer momento. Quando isso acontece, um ThreadAbortException é lançado no thread de destino. Isso pode deixar um estado corrompido e tornar seu aplicativo inutilizável. Por exemplo, chamar Thread.Abort pode impedir que construtores estáticos executem ou impeçam o lançamento de recursos não gerenciados.

Para encerrar a execução do thread, você geralmente usa o modelo de cancelamento cooperativo. Às vezes, não é possível parar um thread de cooperativa, pois ele executa código de terceiros não projetado para cancelamento cooperativo. O Thread.Abort método no .NET Framework pode ser usado para encerrar forçosamente um thread gerenciado. Quando você chama Abort, o Common Language Runtime gera um ThreadAbortException no thread de destino, que pode ser detectado pelo thread de destino.

static void TestMethod()

{

try

{

while (true)

{

Console.WriteLine("New thread running.");

Thread.Sleep(1000);

}

}

catch (ThreadAbortException abortException)

{

Console.WriteLine((string)abortException.ExceptionState);

}

}

Thread newThread = new Thread(new ThreadStart(TestMethod));

newThread.Start();

Thread.Sleep(1000);

// Abort newThread.

Console.WriteLine("Main aborting new thread.");

newThread.Abort("Information from Main.");

// Wait for the thread to terminate.

newThread.Join();

Console.WriteLine("New thread terminated - Main exiting.");

Após a anulação de um thread, ele não poderá ser reiniciado. Se Abort for chamado em um thread que não foi iniciado, o thread será anulado quando Start for chamado. Se Abort for chamado em um thread bloqueado ou estiver em suspensão, o thread será interrompido e anulado. Se Abort for chamado em um thread que foi suspenso, um ThreadStateException será gerado no thread que chamou Aborte AbortRequested será adicionado à propriedade ThreadState do thread que está sendo anulado. Uma ThreadAbortException não é lançada no thread suspenso até que Resume seja chamado. Se Abort for chamado em um thread gerenciado enquanto estiver executando código não gerenciado, um ThreadAbortException não será lançado até que o thread retorne para o código gerenciado.

O método Abort não causa a anulação imediata do thread, porque o thread de destino pode capturar o ThreadAbortException e executar valores arbitrários de código em um bloco finally. Você poderá chamar Thread.Join se precisar esperar até que o thread seja encerrado. Thread.Join é uma chamada de bloqueio que não retorna até que o thread realmente tenha parado de executar ou um intervalo de tempo limite opcional tenha transcorrido. O thread anulado poderia chamar o método ResetAbort ou executar o processamento não associado em um bloqueio finally, então se você não especificar um tempo limite, não será garantido o término da espera.

O Thread.Abort método não tem suporte no .NET Core. Se você precisar encerrar a execução de código de terceiros de modo forçado no .NET Core, execute-o no processo e uso separados Process.Kill . Uma maneira melhor de interromper um thread é usando uma variável compartilhada para que seu destino e seu thread de chamada possam acessar. O código abaixo mostra um exemplo.

private static bool stopped = false;

static void Main(string[] args)

{

Thread newThread = new Thread(new ThreadStart(TestMethod));

newThread.Start();

Thread.Sleep(1000);

//t.Start();

Console.WriteLine("Press any key to exit");

Console.ReadKey();

stopped = true;

newThread.Join();

}

static void TestMethod()

{

try

{

while (!stopped)

{

Console.WriteLine("New thread running.");

Thread.Sleep(1000);

}

}

catch (ThreadAbortException abortException)

{

Console.WriteLine((string)abortException.ExceptionState);

}

}

TRABALHANDO COM TAREFAS

Na maioria das vezes, você precisa executar algum trabalho de forma unitária e recuperar o resultado sem precisar se preocupar com a implementação subjacente no sistema operacional. Com o .NET 4, a Microsoft apresentou uma nova biblioteca, a TPL (Task Parallel Library), que é uma coleção de classes projetadas para abstrair os threads. Task é uma parte importante da Task Parallel Library, essa unidade de trabalho representa uma operação assíncrona e pode ser executada independentemente.

| Comparação | Threads | Tasks |

|---|---|---|

| Namespace | System.Threading | System.Threading.Tasks |

| Definição | 1. É uma forma de um processo dividir a si mesmo em duas ou mais tarefas que podem ser executadas concorrentemente. 2. É algo mais próximo do concreto. É um dos muitos possíveis trabalhadores que executa essa tarefa. |

1. Representa uma unidade de trabalho que deverá ser realizada, é uma promessa, ou seja, uma Task<T> promete devolver um T em algum momento mais tarde. 2. É algo mais abstrato. É algo que você deseja fazer, está se dizendo que precisa de algo pronto em algum momento futuro. |

| Exemplo | Thread.Sleep() consome processamento para esperar um tempo | Task.Delay() cria uma interrupção no processador (através do OS) para o código ser invocado. |

| Retorno | Não há mecanismo direto para retornar o resultado. | Pode retornar um resultado |

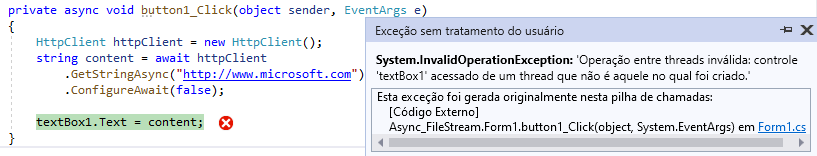

| Exceção | Se ocorrer uma exceção não é possível capturá-la na função Pai. | Uma Task filha pode propagar para a Task pai. |

| Cancelamento | Não é possível cancelar um vez enfileirada na ThreadPool. | Suporta o cancelamento de tarefas através do uso de tokens de cancelamento |

| Operação assíncrona | São usadas para concluir operação assíncrona, quebrando o trabalho em pedaços e atribuindo-os as threads separados em segundo plano. | Representa uma operação assíncrona. Podemos usar as palavras chaves ‘async’ e ‘await’ para implementar facilmente operações assíncronas em uma Task ou Tasks encadeadas(pai/filho). |

| Custo | Uma thread quase sempre não é desejável, pois tem um alto custo, assim é mais fácil reutilizar uma thread existente do ThreadPool. | Nem todas as Tasks precisam de uma nova Thread. Se o sistema tiver várias Tasks, então ele faz uso do ThreadPool e, portanto, não tem a sobrecarga associada à criação de uma thread dedicada usando uma Thread. Reduz o tempo de comutação entre vários threads. |

| Thread | Ao iniciar um thread, esse thread compete com outros threads da CPU para executar. Às vezes, um thread é interrompido no meio de uma operação e deve aguardar sua vez de executar novamente para poder concluir essa operação. O thread interrompe todas as threads de segundo plano quando a de primeiro plano termina. | Oferece melhor controle programático para executar e aguardar uma tarefa. Permite encadear várias tarefas (relacionamento pai/filho) e pode executar cada tarefa uma após a outra usando ContinueWith().Task aguarda que todos os objetos de tarefas fornecidos concluam a execução. |

using System;

using System.Threading;

using System.Threading.Tasks;

Console.WriteLine("Iniciando uma Thread com delay de 5 s");

//Threads

Thread th = new Thread(() =>

{

Thread.Sleep(5000);

});

Console.WriteLine("Iniciando uma Task com delay de 5 s");

//Tasks

Task t = Task.Factory.StartNew(() =>

{

Thread.Sleep(5000);

});

Ao executar o código você vai notar que na execução da Thread vai esperar pelos 5 segundos até terminar. Já a execução da Task ocorre instantâneamente sem o delay de 5 segundos. O que acontece é que no caso da Task é criada uma thread em background para a qual a thread principal não vai aguardar a execução para concluir.

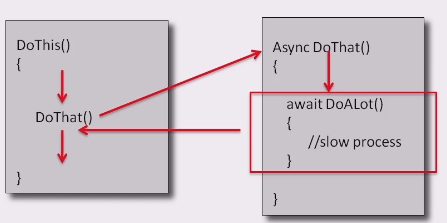

Task

Uma tarefa representa uma unidade de trabalho que deverá ser realizada. Esta unidade de trabalho pode rodar em uma thread separada e é também possível iniciar uma task de forma sincronizada a qual resulta em uma espera pela thread chamada. Com tarefas, você tem uma camada de abstração, mas também um bom controle sobre as threads relacionadas.

As tarefas permitem muito mais flexibilidade na organização do trabalho que você precisa fazer. Por exemplo, você pode definir continuar o trabalho, que deve ser feito depois que uma tarefa esteja completa. Isso pode diferenciar se uma tarefa foi executada com sucesso ou não. Você também pode organizar as tarefas em hierarquia onde uma tarefa pai pode criar novas tarefas filhas que pode criar dependências e assim o cancelamento da tarefa pai também cancela suas tarefas filhas. A tarefa não cria novos threads, em vez disso, gerencia com eficiência os threads do ThreadPool. As tarefas são executadas pelo TaskScheduler, que enfileira tarefas em threads.

Trabalhando com o TaskScheduler

O trabalho de enfileirar tarefas nos threads é realizado por um componente chamado agendador de tarefas, implementado pela classe TaskScheduler. Normalmente, você não trabalha diretamente com o agendador. Quando você inicia uma nova tarefa, se não estiver especificando nenhum agendador, ele usará um padrão. Há uma situação, no entanto, que você precisa usar o agendador ao usar tarefas e é quando você usa tarefas em um aplicativo Windows Forms ou WPF. Nestes tipo de aplicações, a interface do usuário poderá ser atualizada apenas pelo thread da interface do usuário (utilizando o método Invoke) senão congelará a tela para usuário, como abaixo:

static int Soma(object imageOne, object imageTwo, object imageThree)

{

return (int)imageOne + (int)imageTwo + (int)imageThree;

}

var tf = Task<int>.Factory;

// Load the three images asynchronously

var imageOne = tf.StartNew(() => { Thread.Sleep(100); return 10; });

var imageTwo = tf.StartNew(() => { Thread.Sleep(1000); return 50; });

var imageThree = tf.StartNew(() => { Thread.Sleep(50000); return 30; });

// When they’ve been loaded, blend them

var blendedImage = tf.ContinueWhenAll(

new[] { imageOne, imageTwo, imageThree }, _ =>

Soma(imageOne.Result, imageTwo.Result, imageThree.Result));

Task.WhenAll(imageOne, imageTwo, imageThree);

label1.Text = (int)imageOne + (int)imageTwo + (int)imageThree;

Para conseguir atualizar a inteface do usuário, você precisa chamar uma das sobrecargas StartNew ou ContinueWith que usa um parâmetro TaskScheduler e passa TaskScheduler.FromCurrentSynchronizationContext() como o valor para esse parâmetro.

var ui = TaskScheduler.FromCurrentSynchronizationContext();

// When they’ve been loaded, blend them

var blendedImage = tf.ContinueWhenAll(

new[] { imageOne, imageTwo, imageThree }, _ =>

Soma(imageOne.Result, imageTwo.Result, imageThree.Result));

// When we’re done blending, display the blended image

blendedImage.ContinueWith(_ =>

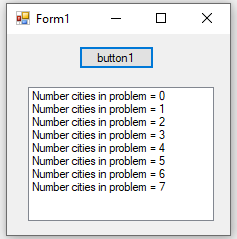

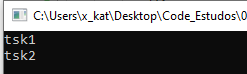

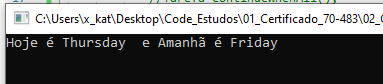

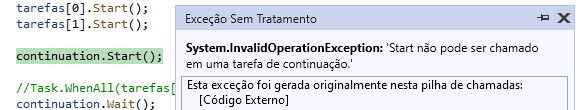

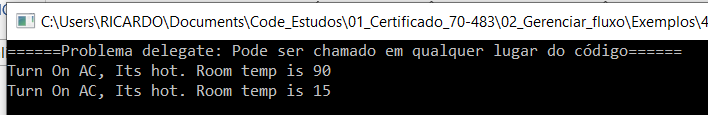

{